Foto de Petra Molnar por Kenya-Jade Pinto, uso com autorização.

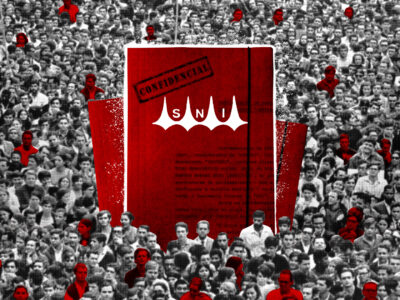

Ativistas estimam que, em 2022, 30 milhões de pessoas se deslocaram como refugiados, muitos dos quais tentaram buscar proteção nos Estados Unidos e na União Europeia. Mas o que eles frequentemente experimentam ao entrar nos países ocidentais não é proteção, mas sim um processo desumano de categorização conduzido fortemente pela inteligência artificial (IA) e por tecnologia não controlada.

A Global Voices entrevistou por e-mail Petra Molnar, advogada e antropóloga especializada em tecnologia, migração e direitos humanos. Petra é cocriadora do Migration and Technology Monitor, um coletivo da sociedade civil, de jornalistas, acadêmicos e cineastas que questiona os experimentos tecnológicos aplicados em pessoas que atravessam fronteiras. Ela também é diretora associada do Refugee Law Lab da Universidade de York e membro do Berkman Klein Center for Critical Internet da Universidade de Harvard. Atualmente, está escrevendo seu primeiro livro, Artificial Borders (The New Press, 2024).

Filip Noubel (FN): A sua pesquisa mostra que os refugiados e os campos onde são mantidos – frequentemente espaços fora da lei – são usados para testar novas tecnologias. Você poderia nos dar alguns exemplos?

Petra Molnar (PM) Borders and spaces of humanitarian emergency like refugee camps are increasingly testing out new technologies for migration control. Since 2018, I have been spending time with people who are at the sharpest edges of technological innovation. From the Arizona desert at the US/Mexico border to the Kenya-Somalia border, to various refugee camps in the EU, we have seen first-hand the impacts of border surveillance and automation on people’s lives.

Before you even cross a border, you may be subject to predictive analytics used in humanitarian settings or biometric data collection. At the border, you can see drone surveillance, sound-cannons, and thermal cameras. If you are in a European refugee camp, you will interact with algorithmic motion detection software. You may be subject to projects like voice printing technologies and the scraping of your social media records. Borders themselves are also changing, as surveillance is expanding our understanding of the European border beyond its physical limits, creating a surveillance dragnet as far as north and Sub-Saharan Africa and the Middle East.

These experimental and high-risk technologies occur in an environment where technological solutions are presented as a viable solution to complex social issues, creating the perfect ecosystem for a lucrative ecosystem giving rise to a multi-billion euro border industrial complex.

In my fieldwork, I notice that people share feelings of being constantly surveilled, or being reduced to data points and fingerprints. Many point out how strange it seems that vast amounts of money are being poured into high-risk technologies while they cannot get access to a lawyer or have psychosocial support. There is also a central misapprehension at the centre of many border tech projects – that somehow more technology will stop people from coming. But that is not the case, in fact people will be forced to take more dangerous routes, leading to even more loss of life at the world’s borders.

Petra Molnar (PM): Petra Molnar (PM) Fronteiras e espaços de emergência humanitária, como campos de refugiados, estão testando cada vez mais novas tecnologias para o controle da migração. Desde 2018, passo tempo com pessoas que estão na vanguarda da inovação tecnológica. Do deserto do Arizona na fronteira EUA/México à fronteira Quênia-Somália, passando por vários campos de refugiados na UE, temos visto em primeira mão os impactos da vigilância e automação de fronteiras na vida das pessoas.

Antes mesmo de cruzar uma fronteira, você pode estar sujeito a análises preditivas usadas em contextos humanitários ou coleta de dados biométricos. Na fronteira, você pode ver drones de vigilância, canhões de som e câmeras termográficas. Se você estiver em um campo de refugiados europeu, estará interagindo com um software de detecção de movimento baseado em algoritmo. Você pode ser alvo de projetos como tecnologias de impressão de voz e rastreamento de seus registros nas redes sociais. As próprias fronteiras também estão mudando, pois a vigilância está ampliando nossa percepção da fronteira europeia além de seus limites físicos, criando uma rede de vigilância até o norte e a África subsaariana e o Oriente Médio.

Estas tecnologias experimentais e de alto risco ocorrem em um ambiente onde a tecnologia é apresentada como uma solução viável para questões sociais, criando o ecossistema lucrativo perfeito, que dá origem a um complexo de fronteira industrial de bilhões de euros.

Em meu trabalho de campo, percebo que as pessoas têm a sensação de serem constantemente observadas ou reduzidas a pontos de dados e impressões digitais. Muitos apontam como é estranho que grandes quantias sejam investidas em tecnologias de alto risco, enquanto elas não podem ter acesso a um advogado ou receber apoio psicossocial. Há também um equívoco no cerne de muitos projetos de tecnologia de fronteira – que, de alguma forma, impedirá a vinda de pessoas. Mas não é assim e, na verdade, as pessoas serão forçadas a seguir rotas mais perigosas, o que causará ainda mais perdas de vidas nas fronteiras do mundo.

FN: A inovação costuma ser apresentada como um termo positivo, mas algumas empresas tecnológicas se dedicam a testar novas tecnologias com refugiados. Por que alguns governos permitem isso?

PM: The creation of legal black holes in migration management technologies is deliberate to allow for the creation of opaque zones of technological experimentation that would not be allowed to occur in other spaces. Why does the private sector get to determine what we innovate on and why, in often problematic public-private partnerships which states are increasingly keen to make in today’s global AI arms race? Private companies like Palantir Technologies, Airbus, Thalys, and others that have links to a host of human rights abuses have now become the preferred vendor for various governments and are even working with international organizations like the World Food Program.

PM: A criação de buracos negros legalizados em tecnologias de gerenciamento de migração é deliberada para permitir a criação de zonas opacas de experimentação tecnológica que não seriam permitidas em outros lugares. Por que é o setor privado que determina o que inovamos e por que, quando nas muitas vezes problemáticas, as parcerias público-privadas se mostram dispostas a se estabelecer na atual corrida armamentista mundial de IA? Empresas privadas como Palantir Technologies, Airbus, Thalys e outras com vínculos contra os direitos humanos tornaram-se agora fornecedoras preferenciais de vários governos e até trabalham com organizações internacionais como o Programa Alimentar Mundial.

FN: Documentar uma violação é um grande desafio por si só. Você pode explicar por quê?

PM: Trying to document these systems of technological oppression is itself a risky business – one fraught with trying to unravel opaque decisions, secretive private sector players, and witnessing horrific conditions on the frontiers challenging our common humanity. It’s also about asking broader questions. Are human rights framings enough or do they also silence the systemic and collective nature of these harms? And are we doing enough to create space for abolitionist conversations when it comes to technology at the border?

In order to tell this global story of power, violence, innovation, and contestation, I rely on the sometimes-uneasy mix between law and anthropology. It’s a slow and trauma-informed ethnographic methodology, one which requires years of being present to begin unravelling the strands of power and privilege, story and memory that makes up the spaces where people’s lives unfold.

Technology replicates power structures in society. Unfortunately, the viewpoints of those most affected are routinely excluded from the discussion. We also need to recognize that the use of technology is never neutral. It is a political exercise which highlights how the allure of quick fixes and the hubris of innovation does not address the systemic and historical reasons why people are marginalized and why they are forced to migrate in the first place.

PM: Tentar documentar esses sistemas de opressão tecnológica é em si um negócio arriscado – repleto de tentativas para desvendar decisões opacas, agentes secretos do setor privado e testemunhar condições horríveis nas fronteiras que desafiam nosso senso de humanidade. É também sobre fazer perguntas mais amplas. Os marcos de direitos humanos são suficientes, ou também silenciam o sistema natural e coletivo desses danos? E nós estamos fazendo o suficiente para criar espaços de conversas abolicionistas quando se trata de tecnologia na fronteira?

Para contar esta história global de poder, violência, inovação e contradição, eu recorro a uma mistura, às vezes difícil, de direito e antropologia. É uma metodologia etnográfica lenta e traumática, que requer anos de presença para começar a desvendar os fios do poder e do privilégio, da história e da memória, que compõem os espaços que se desenrolam na vida das pessoas.

A tecnologia reproduz as estruturas de poder da sociedade. Infelizmente, os pontos de vista mais afetados são muitas vezes excluídos do debate. Também devemos reconhecer que o uso da tecnologia nunca é neutro. Este é um exercício político que destaca o atrativo das soluções rápidas e a prepotência da inovação que falham na abordagem das razões sistêmicas e históricas pelas quais as pessoas são marginalizadas e forçadas a migrar.

FN: Como podemos enfrentar esta situação?

PM: At the Refugee Law Lab, we are trying to both shine a light on the human rights abuses in the use of technology at the border, as well as to look at technical solutions to these complex problems.

One of the main issues is that little to no regulation exists to govern the development of high-risk border tech. When things go wrong with these high risk experiments, where does responsibility and liability lie – with the designer of the technology, its coder, the immigration officer, or the algorithm itself? Should algorithms have legal personality in a court of law, not unlike a corporation? It is paramount that we begin to answer these questions, since much of the decision-making related to immigration and refugee decisions already sits at an uncomfortable legal nexus: the impact on the rights of individuals is significant and life-changing, even where procedural safeguards are weak.

The EU’s proposed AI Act is a promising step as it will be the first regional attempt in the world to regulate AI. However currently the act does not go far enough to adequately protect people-on-the-move. A moratorium or a ban on high-risk border technologies, like robo-dogs, AI lie detectors, and predictive analytics used for border interdictions is a necessary step in the global conversation. Academia also plays an important role in legitimizing high risk experimental technologies. We also need more transparency and accountability around border tech experiments, and people with lived experiences of migration must be foregrounded in any discussions.

Because in the end, it is not really about technology. What we are talking about is power – and the power differentials between actors like states and the private sector who decide on experimental projects, and the communities who become the testing grounds in this high-risk laboratory. For example, whose priorities really matter when we choose to create violent sound cannons or AI-powered lie detectors at the border instead of using AI to identify racist border guards?

PM: No Refugee Law Lab, tentamos tornar visíveis os abusos dos direitos humanos no uso da tecnologia na fronteira, e buscar soluções técnicas para esses problemas complexos.

Um dos principais problemas é que quase não existem normas que regulem o desenvolvimento de tecnologias fronteiriças de alto risco. Quando as coisas dão errado nesses experimentos de alto risco, onde está a responsabilidade: no designer da tecnologia, no programador, no oficial de imigração ou no próprio algoritmo? Os algoritmos deveriam ter personalidade jurídica em um tribunal, assim como uma empresa? É primordial que comecemos a responder a estas questões, uma vez que grande parte da tomada de decisões relacionadas com a imigração e os refugiados se encontra num nexo jurídico incômodo: o impacto nos direitos dos indivíduos é significativo e transformador, inclusive quando as garantias processuais são fracas.

A Lei de IA proposta pela UE é um passo promissor, já que esta será a primeira tentativa regional no mundo de regulamentar a inteligência artificial. No entanto, atualmente, a lei não tem o alcance suficiente para proteger de modo adequado as pessoas em movimento. Uma moratória ou proibição de tecnologias de fronteira de alto risco, como cães robôs, os detectores de mentiras de IA e as análises preditivas usadas para interdições de fronteira é um passo necessário no debate global. A academia também desempenha um papel importante na legitimação de tecnologias experimentais de alto risco. Também precisamos de mais transparência e responsabilidade em relação aos experimentos tecnológicos de fronteira, e as pessoas com experiências vividas de migração devem estar em primeiro plano em qualquer discussão.

Porque, no final, não se trata realmente de tecnologia. Estamos falando de poder – e dos diferenciais de poder entre atores como os estados e o setor privado que decidem sobre projetos experimentais, e as comunidades que se tornam os campos de testes neste laboratório de alto risco. Por exemplo, quais prioridades realmente importam quando escolhemos criar violentos canhões sonoro ou detectores de mentiras na fronteira, em vez de usar IA para identificar guardas fronteriças racistas?

Este é um vídeo do evento organizado pelo Disruption Network Lab, no qual Molnar desenvolve sua visão sobre a questão do uso da tecnologia e os direitos dos refugiados: